최신논문

Multiagent Finetuning: 다양한 추론 체인을 통한 자기 개선

작성자

하이룽룽

작성일

2025-01-14 18:32

조회

263

https://arxiv.org/abs/2501.05707

https://x.com/du_yilun/status/1878851914307371440?t=Ykw_JxHU-NXh32Z3oZbsJA&s=19

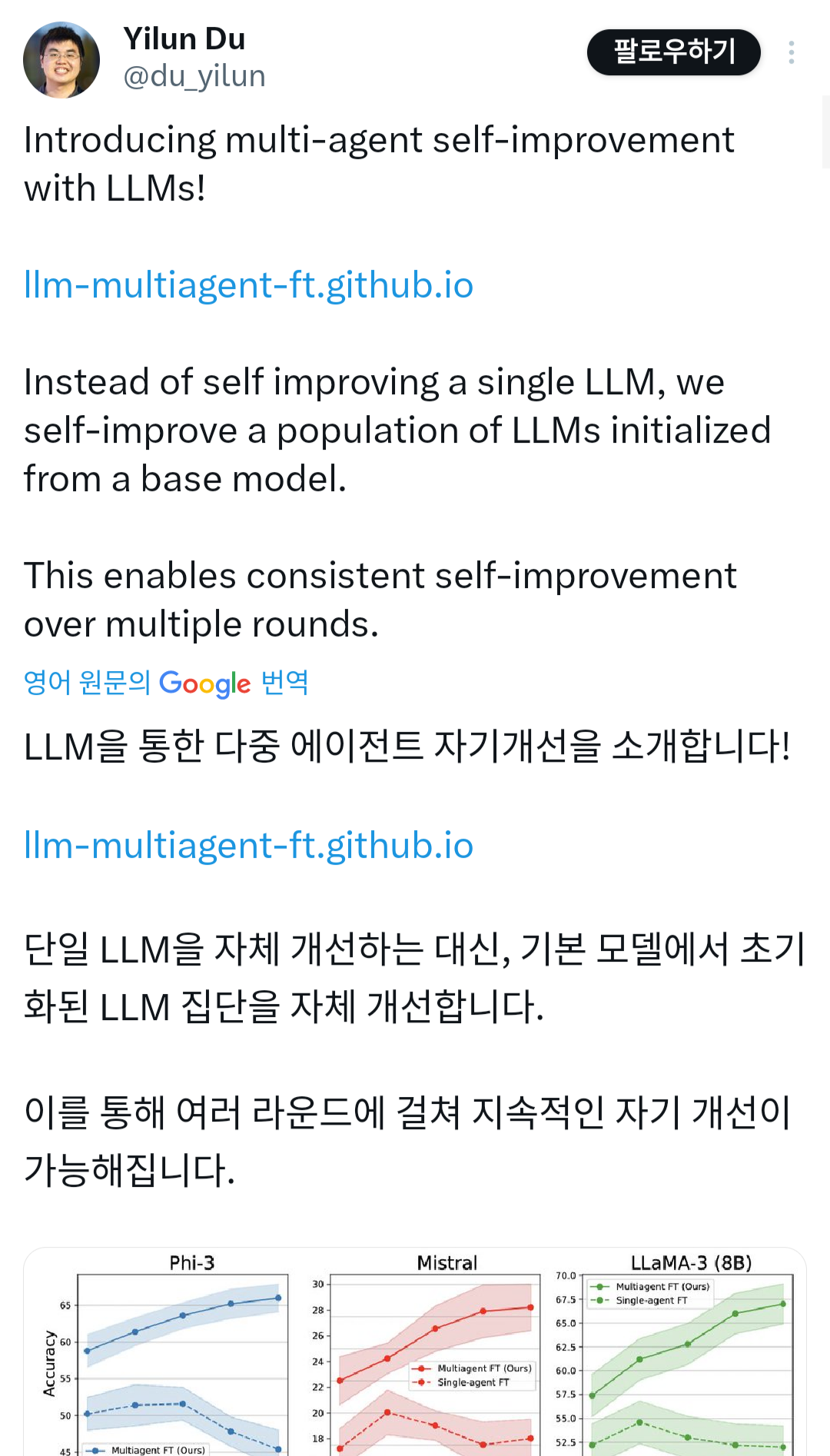

대규모 언어 모델(LLM)은 최근 몇 년 동안 놀라운 성능을 달성했지만 근본적인 훈련 데이터에 의해 제한됩니다. 훈련 데이터를 넘어 모델을 개선하기 위해 최근 연구에서는 LLM을 사용하여 자율적 자기 개선을 위한 합성 데이터를 생성하는 방법을 탐구했습니다. 그러나 자기 계발을 위한 연속적인 단계는 수익이 감소하는 지점에 도달할 수 있습니다. 이 연구에서 우리는 자기 개선에 대한 보완적 접근 방식을 제안하며, 이는 언어 모델의 다중 에이전트 사회에 미세 조정이 적용되는 것입니다. 모두 동일한 기본 모델에서 시작하는 언어 모델 그룹은 모델 간의 다중 에이전트 상호 작용을 통해 생성된 데이터를 사용하여 각 모델을 업데이트하여 독립적으로 전문화됩니다. 독립적인 데이터 집합에서 각 모델을 학습시킴으로써 이 접근 방식을 통해 모델 간 전문화와 모델 집합에 대한 다양화를 가능하게 하는 방법을 설명합니다. 그 결과, 우리의 전체 시스템은 다양한 추론 체인을 보존하고 단일 에이전트 자체 개선 방법보다 훨씬 더 많은 미세 조정을 통해 자율적으로 개선할 수 있습니다. 우리는 광범위한 추론 작업 세트에서 접근 방식의 효율성을 정량적으로 설명합니다.

https://x.com/du_yilun/status/1878851914307371440?t=Ykw_JxHU-NXh32Z3oZbsJA&s=19

대규모 언어 모델(LLM)은 최근 몇 년 동안 놀라운 성능을 달성했지만 근본적인 훈련 데이터에 의해 제한됩니다. 훈련 데이터를 넘어 모델을 개선하기 위해 최근 연구에서는 LLM을 사용하여 자율적 자기 개선을 위한 합성 데이터를 생성하는 방법을 탐구했습니다. 그러나 자기 계발을 위한 연속적인 단계는 수익이 감소하는 지점에 도달할 수 있습니다. 이 연구에서 우리는 자기 개선에 대한 보완적 접근 방식을 제안하며, 이는 언어 모델의 다중 에이전트 사회에 미세 조정이 적용되는 것입니다. 모두 동일한 기본 모델에서 시작하는 언어 모델 그룹은 모델 간의 다중 에이전트 상호 작용을 통해 생성된 데이터를 사용하여 각 모델을 업데이트하여 독립적으로 전문화됩니다. 독립적인 데이터 집합에서 각 모델을 학습시킴으로써 이 접근 방식을 통해 모델 간 전문화와 모델 집합에 대한 다양화를 가능하게 하는 방법을 설명합니다. 그 결과, 우리의 전체 시스템은 다양한 추론 체인을 보존하고 단일 에이전트 자체 개선 방법보다 훨씬 더 많은 미세 조정을 통해 자율적으로 개선할 수 있습니다. 우리는 광범위한 추론 작업 세트에서 접근 방식의 효율성을 정량적으로 설명합니다.

전체 0